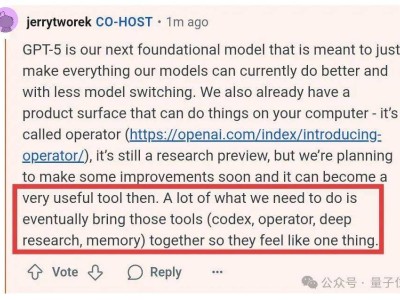

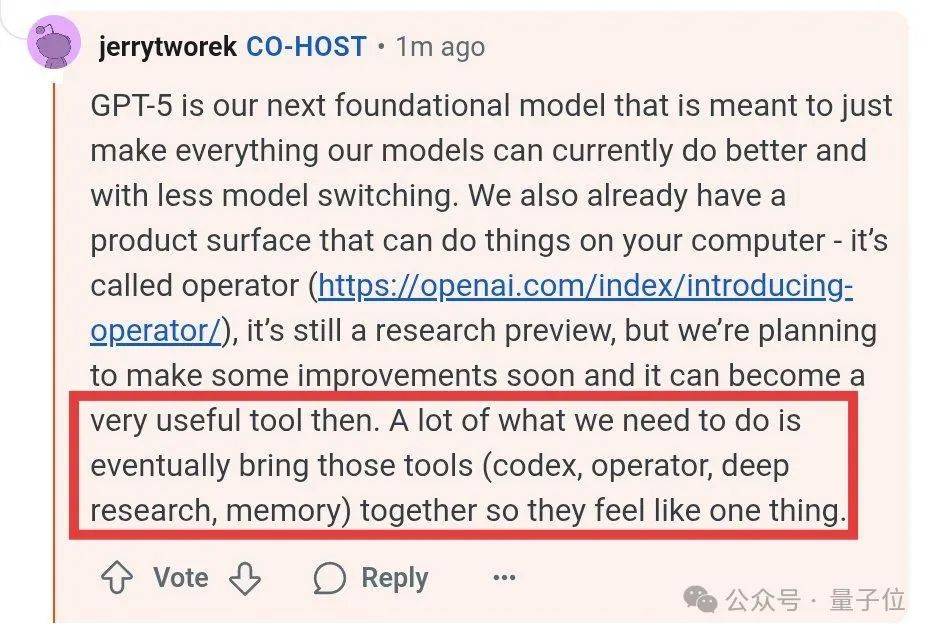

OpenAI近期透露了关于其下一代基础模型GPT-5的重大计划,这一消息引发了业界的广泛关注。在一系列互动活动中,公司研究副总裁Jerry Tworek及Codex团队成员分享了一系列关于GPT-5及其相关工具的详细信息。

据透露,为了优化用户体验并减少模型切换,OpenAI计划将现有的Codex、Operator、Deep Research和Memory等工具整合为一个整体。这一举措旨在提供一个更加流畅和高效的用户界面。

Codex团队在分享中提到,Codex最初是作为一个内部项目诞生的,起因是团队发现OpenAI的日常工作流程中未能充分利用模型潜力。自采用Codex以来,团队内部的编程效率显著提升,大约提高了三倍。这一提升主要得益于Codex能够同时生成多个代码版本,并从中筛选出质量最优的版本。

OpenAI正在探索灵活的定价方案,包括按需付费模式,以更好地满足用户需求。同时,团队还透露了未来可能推出o3-pro或codex-1-pro版本的计划,具体将视团队能力而定。

在问答环节中,OpenAI团队进一步解答了关于Codex的多个关键问题。对于为何选择Type而非Python编写Codex CLI工具,团队表示开发者对Type较为熟悉,且它更适合用于UI(包括终端界面)。尽管目前Codex CLI可以在本地运行,但受限于计算机性能,通常是单线程的。而在云端运行可以实现并行化和沙盒化,提高安全性和效率。

关于GPT-5的未来角色,OpenAI团队强调,其核心目标是提升现有模型的能力,并减少模型切换。目前,Operator已经在计算机上执行任务方面展现出潜力,尽管仍处于研究预览阶段,但未来有望成为非常有用的工具。整合后的工具集将使GPT-5成为一个全方位的助手。

在回答关于Codex是否适合所有工程师的问题时,团队表示,Codex可能对那些处理繁琐问题而非超级难题的工程师更为合适。Codex目前主要利用加载到容器运行时的信息,并不直接访问最新的库文档或通过搜索获取实时信息。不过,OpenAI正在考虑结合检索增强生成(RAG)技术,以解决信息落伍的问题。

在强化学习方面,OpenAI团队在Codex项目中使用了强化学习来提升模型的编码能力、代码风格以及工作准确性。团队对强化学习在LLM和编码领域的应用前景表示乐观。团队还分享了关于未来软件工程愿景的看法,期望能够高效且可靠地将软件需求转化为可运行的软件版本。

最后,OpenAI团队宣布将面向Plus/Pro用户推出免费API积分,供用户使用Codex CLI。OpenAI还发布了“Codex上手指南”,详细介绍了如何连接GitHub、提交任务、运行以及使用提示词技巧等内容,感兴趣的用户可以访问相关链接进行了解。