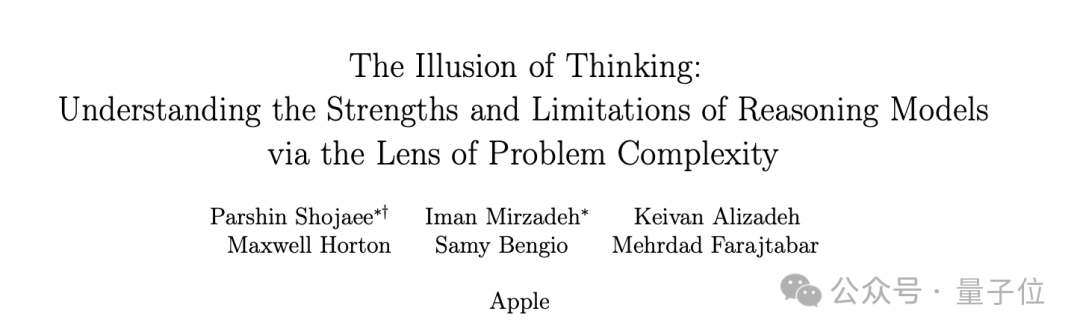

近期,苹果公司在人工智能领域的一篇最新论文引发了广泛讨论。这篇论文对当下大模型的推理能力提出了质疑,指出所谓的“思考”可能只是一种表象。

论文的核心观点在于,当前的主流推理模型,如DeepSeek、o3-mini以及Claude 3.7等,实际上并未进行真正的思考,而是在进行一种高级的模式匹配。在面对高度复杂的任务时,这些模型往往会崩溃,即便给予它们充足的时间和计算资源也难以改变这一现状。

这一观点引起了业界的轩然大波。有网友讽刺苹果,认为其虽然拥有庞大的资金,但在大模型研发上并未取得显著成果,现在却开始否定他人的努力。也有人建议苹果直接收购Claude背后的公司Anthropic,以免错失良机。

然而,论文中提出的观点并非全然消极。作者们实际上是在呼吁业界建立更为完善的推理机制和评估体系。他们指出,当前的评估方法主要集中在数学和编码基准上,主要关注模型输出的正确性,却忽视了“思考过程”的质量。

为了克服这一限制,苹果团队设计了四类谜题环境,包括汉诺塔、跳棋交换、过河问题以及积木世界。这些谜题环境的难度可以精确控制,同时保持逻辑结构的一致性,使得研究者能够系统地观察模型在不同复杂度下的行为变化。

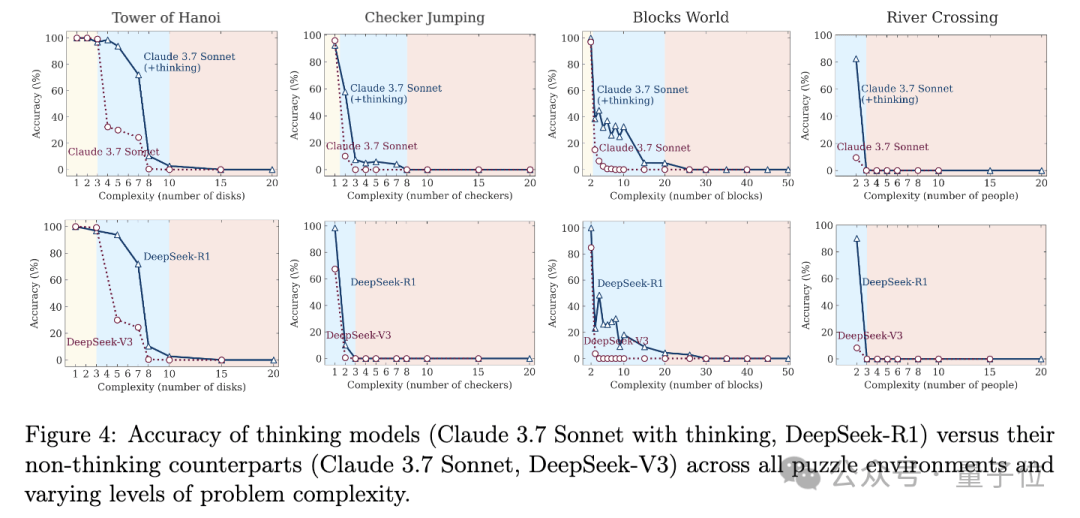

在这些可控环境中,团队进行了大量实验,对比了带有思考机制和不带有思考机制的模型。他们发现,随着任务复杂度的增加,模型的表现呈现出三个截然不同的区间。

在低复杂度任务中,没有思考功能的标准语言模型表现得更为出色,不仅更准确,而且效率更高。这一发现直接挑战了“更多思考总是更好”的直觉假设。然而,随着任务难度进入中等水平,能够生成长思维链的推理模型开始显现优势。但当问题复杂度继续增加并超过某个临界点时,无论是推理模型还是标准模型都会经历性能崩溃。

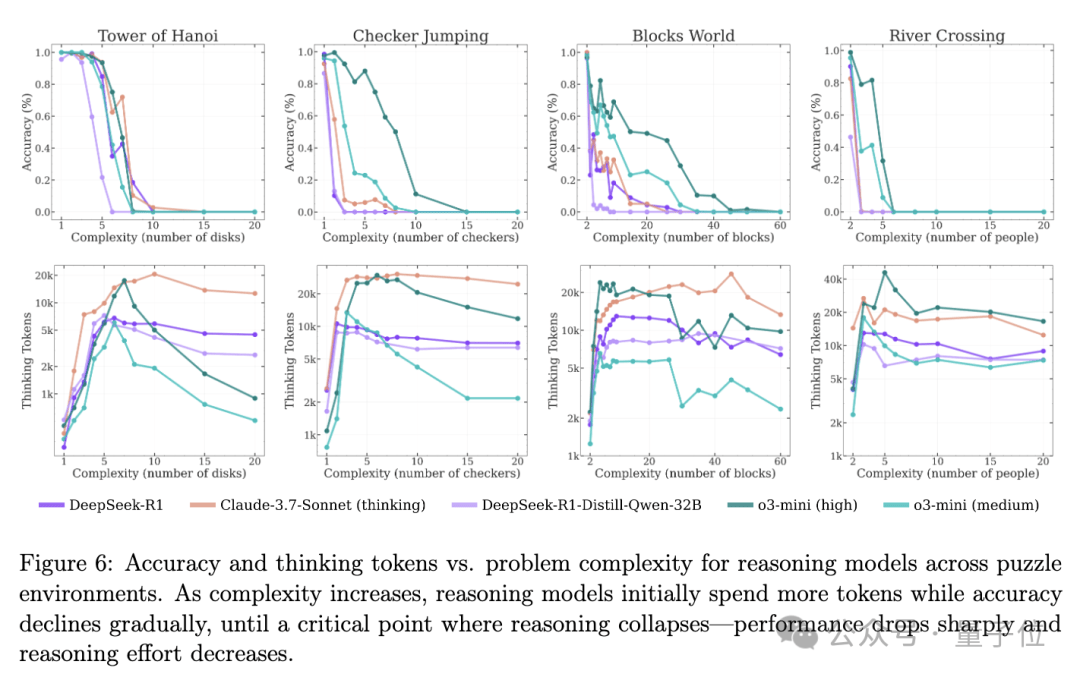

更令人困惑的是,苹果团队观察到了“推理努力反向缩放”现象。即随着问题复杂度的增加,模型在接近崩溃临界阈值时,反而会“主动减少思考”,即使它们的计算资源还远未耗尽。这表明,问题并非出在计算资源的限制上,而是模型本身存在某种内在的计算扩展限制。

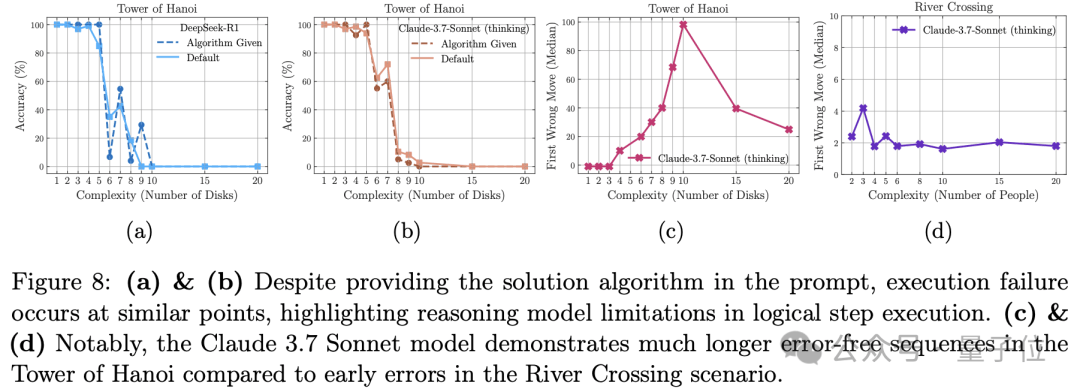

为了深入理解这一现象,团队对Claude-3.7-Sonnet (thinking)模型进行了详细分析。他们发现,在处理简单问题时,推理模型经常会在早期就找到正确的解决方案,但随后却继续探索各种错误的替代方案,造成计算资源的浪费。随着问题复杂度适度增加,这一趋势发生逆转,模型首先探索错误的解决方案,而正确解决方案大多出现在思维的后期。对于更高复杂度的问题,模型则无法生成任何正确的解决方案。

团队还发现,即使在提示中向模型提供了完整的解决算法,模型的失败点几乎没有改变,仍然无法突破任务复杂性限制。这进一步凸显了推理模型在验证和遵循逻辑步骤解决问题方面的局限性。

在论文的最后部分,苹果团队提出,仅用最终答案来评估推理能力存在误导性,还需要关注中间步骤的质量,如逻辑一致性、步骤效率等。他们建议,未来如何设计更鲁棒的推理机制,突破长程依赖和复杂规划的瓶颈,是当前AI研究的关键方向。

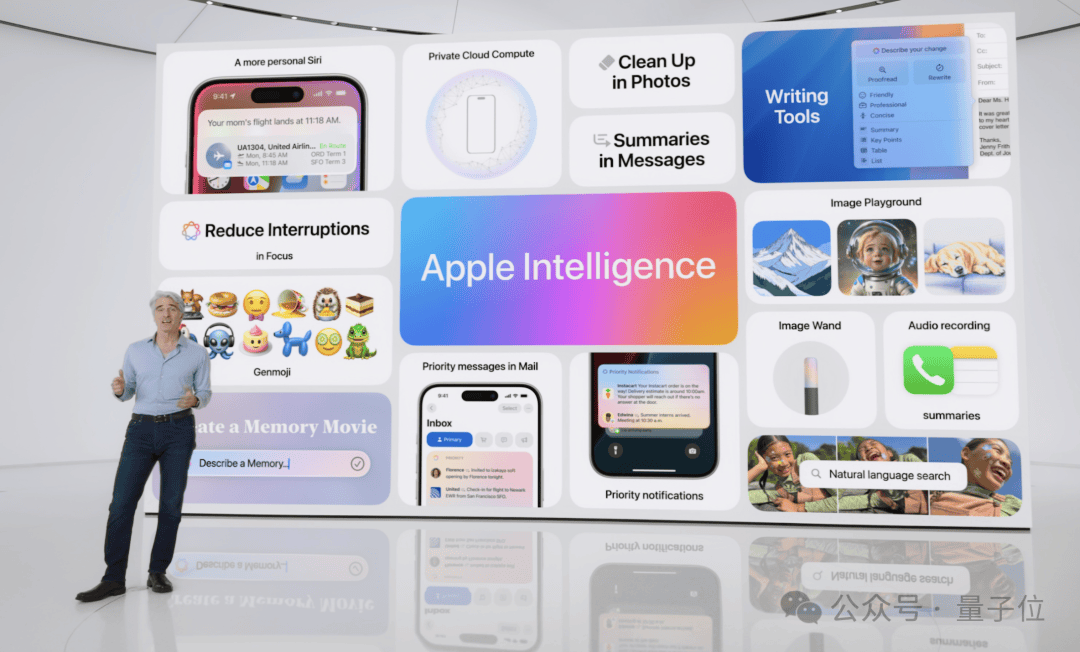

与此同时,业界也在关注苹果在大模型领域的进展。过去一年中,苹果虽然推出了一系列AI功能,但许多都经历了延期、不够完善甚至被下架的命运。这引发了关于苹果是否在大模型领域落后的讨论。