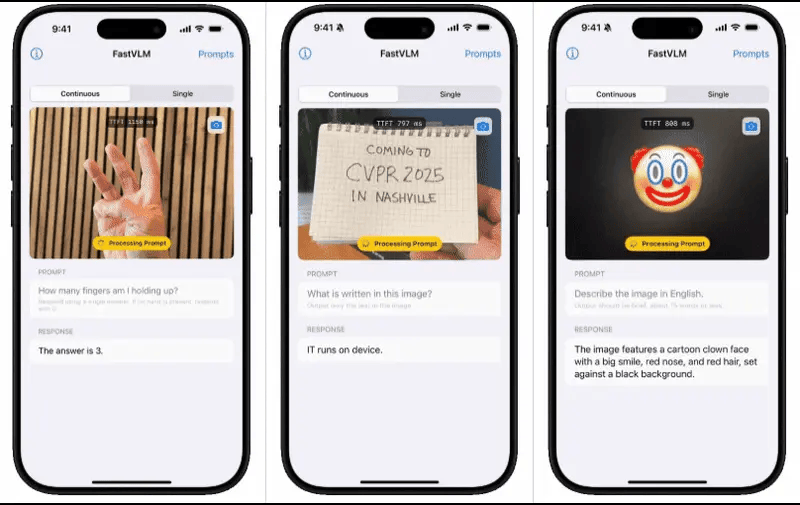

近日,科技新闻界传来消息,苹果公司在Hugging Face平台上悄然推出了一款名为FastVLM的视觉语言模型浏览器试用版本。这款模型以其惊人的视频字幕生成速度引起了广泛关注。

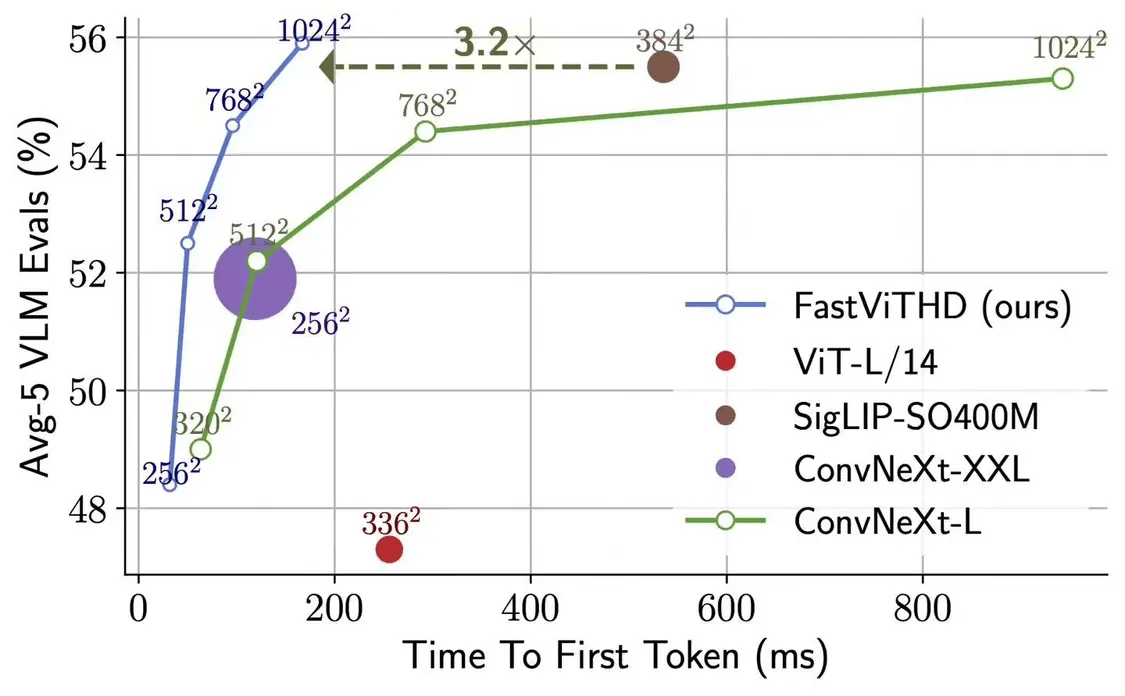

据悉,FastVLM模型的一大亮点是其出色的速度和效率表现。它得益于苹果自研的开源机器学习框架MLX的优化,专为Apple Silicon芯片设计。与同类模型相比,FastVLM的体积大幅缩减至三分之一左右,但在视频字幕生成速度上却能实现85倍的提升。这样的性能表现,无疑为用户带来了更为流畅和高效的使用体验。

苹果此次推出的FastVLM-0.5B轻量版,用户可以直接在浏览器中加载运行。据相关测试显示,在配备16GB内存的M2 Pro MacBook Pro上,首次加载模型可能需要几分钟的时间,但一旦启动,它便能准确地描述画面中的人物、环境、表情以及各种物体,展现出强大的识别和分析能力。

FastVLM模型支持本地运行,这意味着所有数据都在设备端进行处理,无需上传至云端。这一特性不仅提升了数据处理的效率,更重要的是保障了用户的数据隐私安全,让用户在使用过程中更加放心。

FastVLM模型的本地运行能力和低延迟特性,使其在可穿戴设备和辅助技术领域展现出巨大的应用潜力。例如,在虚拟摄像头应用中,FastVLM能够即时且详细地描述多场景内容,为用户提供更加智能和便捷的交互体验。未来,随着技术的不断发展和完善,FastVLM有望成为这些设备的核心技术之一,推动相关领域的技术创新和产业升级。